World Model/UFMs/Omni-Modal: AR vs DiT

导言

视觉领域的GPT moment要来了吗?[^4]

- World Model: (e.g., Emu3.5)

- Unified Foundation Models, UFMs,强调视觉能力的闭环。证明模型能像“看懂”图片一样“画出”图片。(e.g.,Bagel, Lumina, Emu3.5)

- Omni 强调交互能力的闭环。证明模型能像真人一样,具备实时、全感官的反应。图片生成暂时不是必须的(e.g.,Qwen-3-Omni、longcat-omni), 但是也能支持(e.g., Ming-Omni)

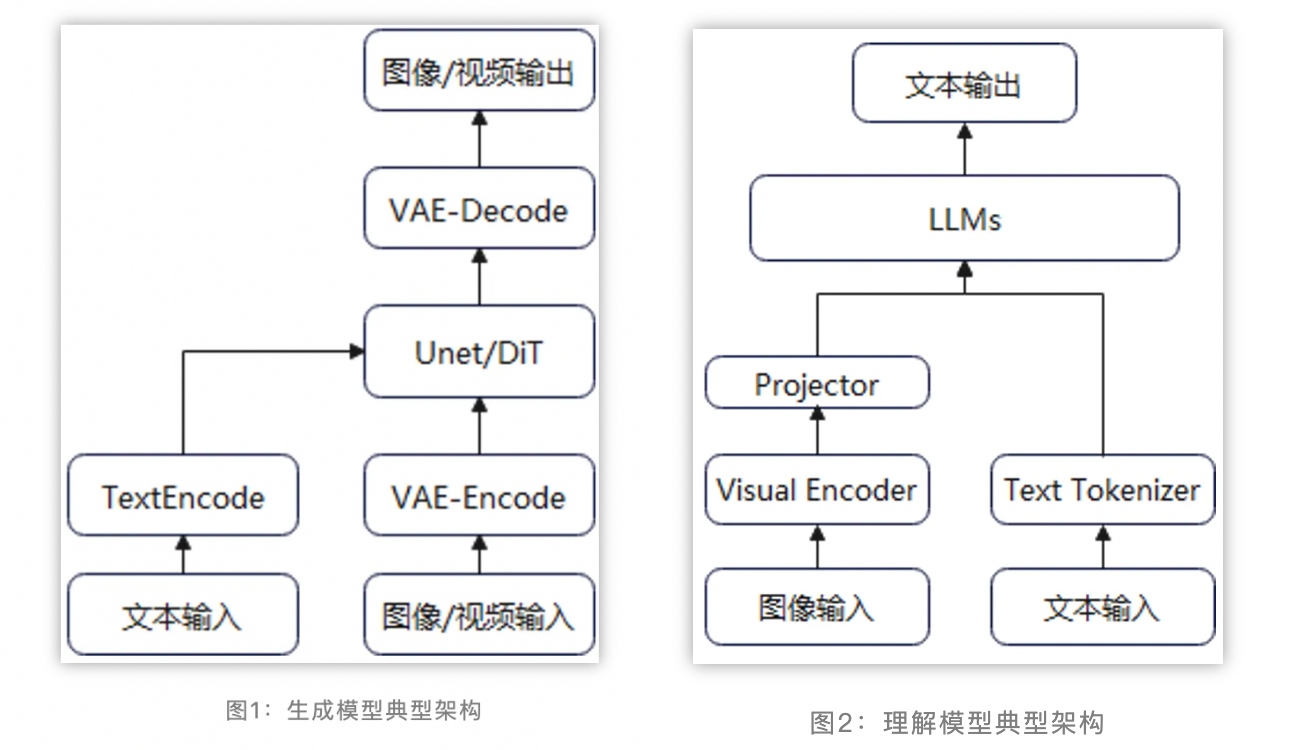

当前多模态设计中AR和DiT的组合关系,单独学习一下

[^1]

[^1]