导言

大语言模型、多模态模型是如何设计来实现高效Mem机制。

World Model/UFMs/Omni-Modal: AR vs DiT

导言

视觉领域的GPT moment要来了吗?[^4]

- World Model: (e.g., Emu3.5)

- Unified Foundation Models, UFMs,强调视觉能力的闭环。证明模型能像“看懂”图片一样“画出”图片。(e.g.,Bagel, Lumina, Emu3.5)

- Omni 强调交互能力的闭环。证明模型能像真人一样,具备实时、全感官的反应。图片生成暂时不是必须的(e.g.,Qwen-3-Omni、longcat-omni), 但是也能支持(e.g., Ming-Omni)

当前多模态设计中AR和DiT的组合关系,单独学习一下

Ideas around Vision-Language Models (VLMs) / Reasoning Models

导言

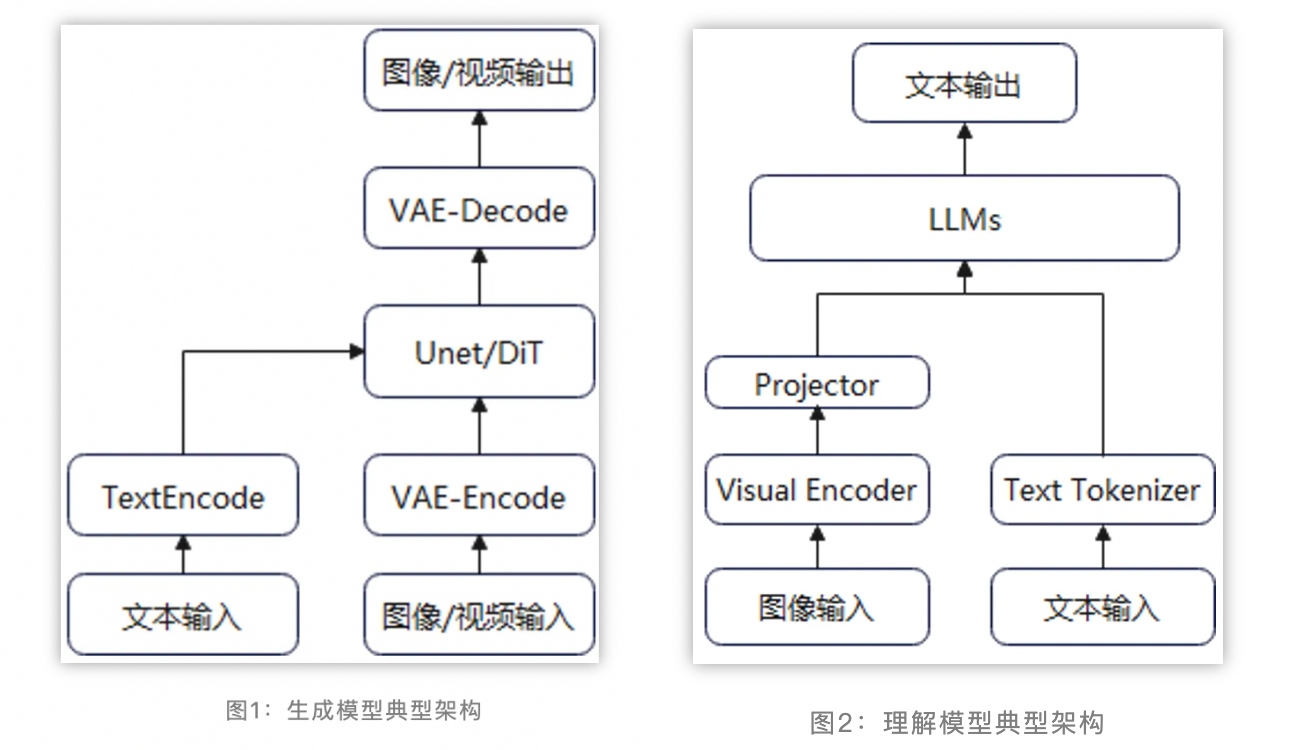

当前主流的多模态理解模型一般采用视觉编码器 + 模态对齐 + LLM的算法流程,充分复用已有视觉编码器的理解能力和LLM的基础能力。训练过程一般分为多个阶段,如先进行模态对齐的一阶段预训练,然后进行二阶段的参数微调。

排行榜:

250217 Step-Video-T2V Reading & Porting

导言

阅读Step-Video-T2V代码(git id d3ca3d6),移植到昇腾。

导言

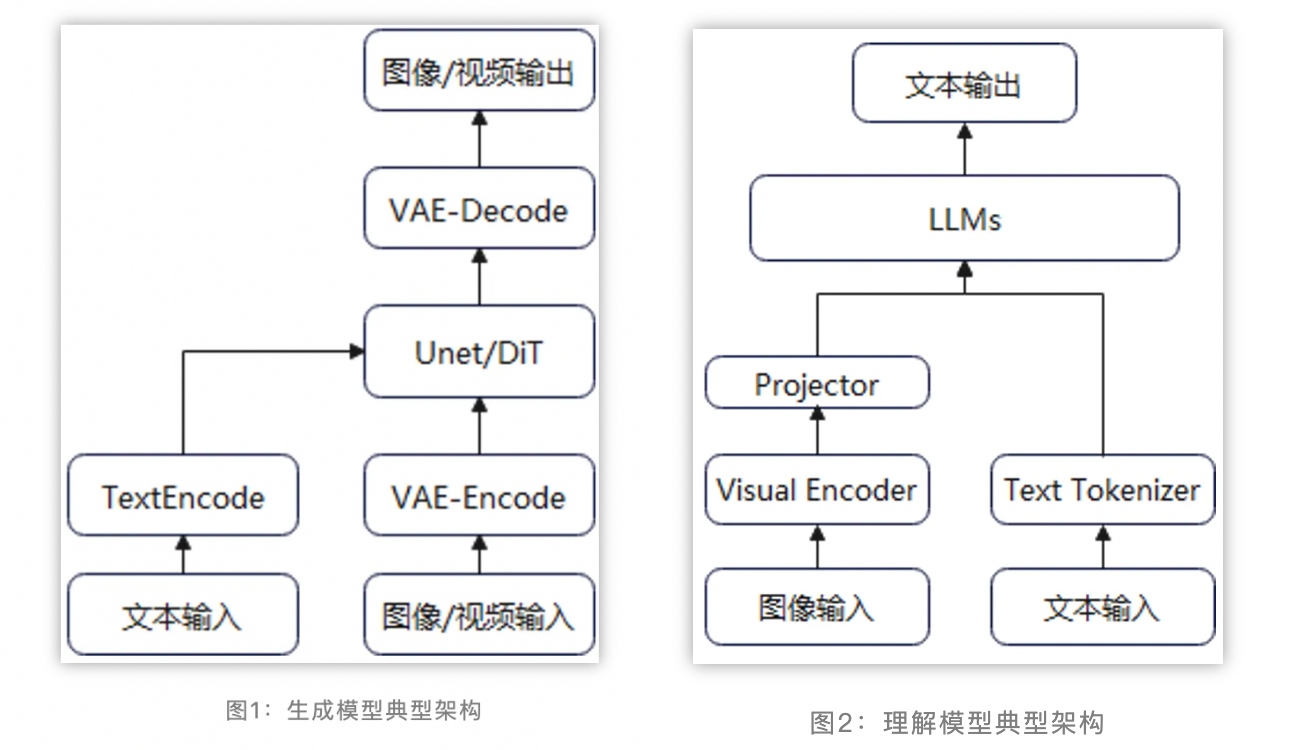

当前主流的多模态生成模型(如图像生成text2image和视频生成text2video)主要采用Latent Stable Diffusion的方案框架。为了减少计算量,图像/视频等模态的数据(噪声)先经过VAE压缩得到Latent Vector,然后在文本信息的指导下进行去噪,最后生成符合预期的图像或视频。

排行榜: (T2I, ImageEdit, T2V, I2V, )

当前主流的多模态生成模型(如图像生成和视频生成)主要采用Latent Stable Diffusion的方案框架。为了减少计算量,图像/视频等模态的数据(噪声)先经过VAE压缩得到Latent Vector,然后在文本信息的指导下进行去噪,最后生成符合预期的图像或视频。

当前主流的多模态理解模型一般采用视觉编码器 + 模态对齐 + LLM的算法流程,充分复用已有视觉编码器的理解能力和LLM的基础能力。训练过程一般分为多个阶段,如先进行模态对齐的一阶段预训练,然后进行二阶段的参数微调。

Categories

- AI6

- Algorithms12

- Architecture41

- Artificial Intelligence45

- Camp1

- Databases2

- HPC1

- Math2

- Network8

- OOW35

- Operating system8

- Overview15

- Programming40

- ProjectRecord3

- Software1

- Thinking11

- Tips9

- Treasure1

- Tutorials118

- Values2

- architecture2

- diary4

- english4

- hardware2

- love1

- math3

- network19

- operating system5

- programming1

- security3

- software23

- thinking9

- tips5

- toLearn55

- values2

Subscribe for updates

follow.it

Recents

Archives

- February 20265

- January 20267

- December 202518

- November 20256

- October 20251

- September 20252

- May 20253

- April 20251

- March 20254

- February 20254

- January 20254

- December 20245

- November 20241

- October 20245

- September 202411

- August 20243

- July 20244

- June 20241

- May 20242

- April 20248

- March 20243

- February 20241

- January 202414

- December 202320

- November 202333

- October 202358

- September 202337

- August 202323

- July 202324

- June 202313

- May 202319

- April 20239

- March 20235

- February 20232

- January 20236

- December 20222

- November 20224

- October 20225

- September 20224

- August 20228

- July 20227

- June 20227

- May 202210

- April 20225

- March 20227

- February 20222

- January 20225

- December 20214

- November 20212

- October 202114

- September 202111

- August 202113

- July 202128