思路

- 写U盘(见网上教程,注意备份U盘文件)

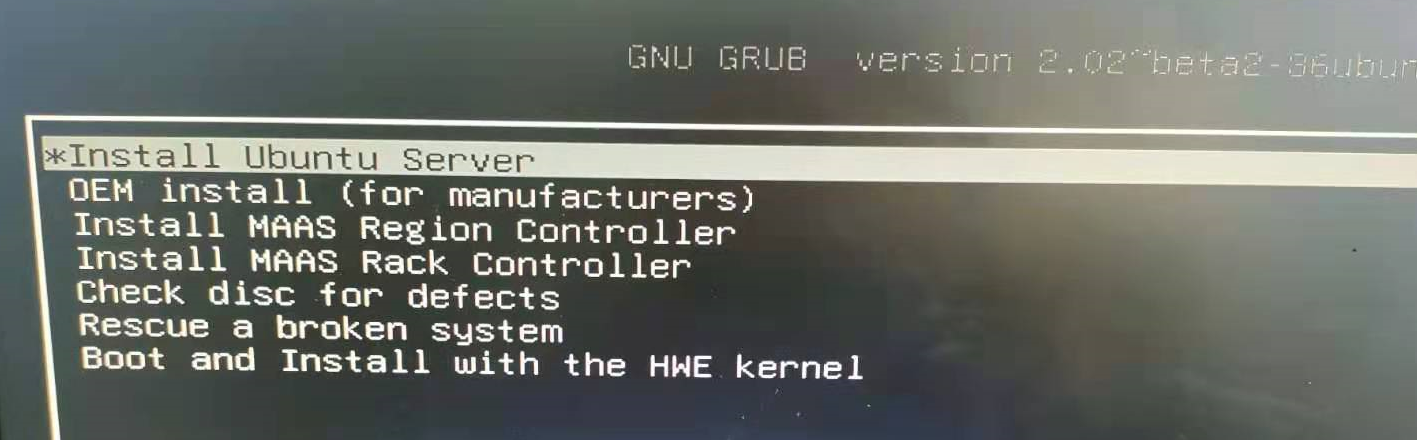

- 插U盘,开机前根据机器型号使用命令(F2,F4, F12或者Del)进入boit manager,选择从U盘boot

- 改引导启动顺序,把U盘启动改到最前面

- 改引导启动顺序,把U盘启动改到最前面

- 根据提示安装ubuntu(服务器不用分区,默认就行,如果自己电脑双系统则需要根据内存设置分区)

- 设置root密码并进入root

sudo passwd root - 配置实验室网络

下载安装包

重装系统怎么保留原本的磁盘文件

只要在安装系统时分出一个/home分区。你可以把Ubuntu的“/”分区看为Windows的C盘,重装Ubuntu时只格式化“/”分区,不格式化“/home”,这样就可以保留“/home”中的数据了。使用的时候就挂载就行

但是假如一开始没分区:

- 可以插块新盘当作系统盘,系统安装好之后,把旧的文件系统挂载到新系统的某个目录下

- 从旧的文件系统里划出一块区域,安装新系统。

- 在你要安装的目标磁盘中,通过删除卷和删除分区操作腾出一块未分配的磁盘空间作为安装区

从已有分区中提取空间

xfs类型不可以直接缩减,只扩不减。如果是ext2,ext3,ext4可以在线缩减,如果xfs盘要缩小就要删除后重新添加

非系统根分区LVM缩容

- 取消挂载

系统根分区无法在线取消挂载,所以这时请勿对系统根分区执行任何缩容操作1

umount /lv/ #取消挂载目录

- e2fsck检查修复磁盘完整性

1

e2fsck -f /dev/vg0/lv0

- 缩小系统文件空间,即

df -h查看的空间

不取消挂载,这步会报错,注:一定先减文件系统,再减逻辑卷1

resize2fs /dev/vg0/lv0 10G

- 缩小磁盘空间,即lsblk查看的空间

不执行上面的操作,直接执行这步,虽然成功,但是会操作数据丢失,系统无法启动。1

lvreduce -L 10G /dev/vg0/lv0

- 重新挂载 最后查看lvs空间

1

mount -a

系统根分区LVM缩容(救援模式)

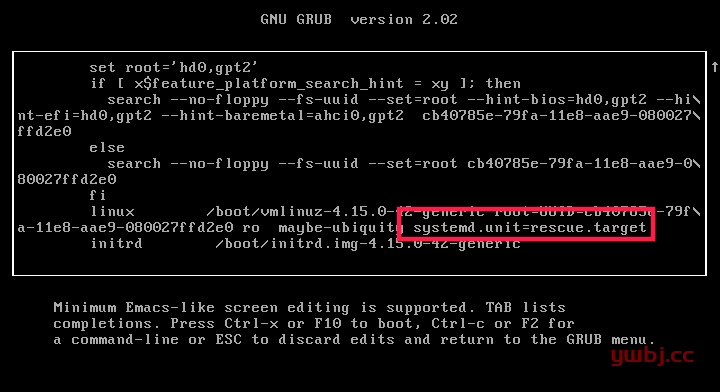

正常启动系统进入救援模式 :启动按shift键,出现选择系统界面,按e。找到以单词 linux 开头的行,并在该行的末尾添加以下内容(要到达末尾,只需按下 CTRL+e 或使用 END 键或左右箭头键):

1 | systemd.unit=rescue.target |

添加完成后,只需按下 CTRL+x 或 F10 即可继续启动救援模式。几秒钟后,你将以 root 用户身份进入救援模式(单用户模式)

需要进一步的研究学习

遇到的问题

暂无

开题缘由、总结、反思、吐槽~~

参考文献

https://blog.csdn.net/weixin_40018873/article/details/109537532